Stability AI kündigte am Donnerstag Stable Diffusion 3 an, ein Bildsynthesemodell der nächsten Generation mit offenen Gewichten. Es folgt seinen Vorgängern und erstellt detaillierte Bilder mit mehreren Motiven mit verbesserter Qualität und Genauigkeit bei der Texterstellung. Die kurze Ankündigung wurde nicht von einer öffentlichen Demo begleitet, wohl aber von Stabilität Offene Warteliste Heute ist für diejenigen, die es ausprobieren möchten.

Laut Stable reicht die Größe der Stable Diffusion 3-Modellfamilie (die Textbeschreibungen, sogenannte „Eingabeaufforderungen“, in entsprechende Bilder umwandelt) von 800 Millionen bis 8 Milliarden Parametern. Die Skalierung ermöglicht die lokale Ausführung verschiedener Versionen des Modells auf einer Vielzahl von Geräten – von Smartphones bis hin zu Servern. Die Parametergröße entspricht in etwa der Fähigkeit des Modells hinsichtlich der Detailgenauigkeit, die es generieren kann. Größere Modelle erfordern zum Betrieb auch mehr VRAM auf den GPU-Beschleunigern.

Seit 2022 haben wir gesehen, wie Stable seine Weiterentwicklung der KI-Bilderzeugungsmodelle auf den Markt bringt: Stable Diffusion 1.4, 1.5, 2,0, 2.1, XL, XL Turbo und jetzt 3. Stability hat sich einen Namen als offenere Alternative zu proprietären Bildsynthesemodellen wie DALL-E 3 von OpenAI gemacht, obwohl es aufgrund der Verwendung von urheberrechtlich geschütztem Training nicht unumstritten ist Daten. Voreingenommenheit und Missbrauchspotenzial. (Dies führte zu ungelösten Rechtsstreitigkeiten.) Die Steady-State-Diffusionsmodelle waren offen gewichtet und Open Source, was bedeutete, dass die Modelle lokal ausgeführt und angepasst werden konnten, um ihre Ergebnisse zu ändern.

-

Stable Diffusion 3 Generation mit Claim: Episches Kunstwerk eines Zauberers auf einem Berggipfel bei Nacht, der einen kosmischen Zauberspruch in den dunklen Himmel wirft und „Stable Diffusion 3“ aus bunter Energie sagt.

-

KI-generiertes Bild einer Großmutter, die ein „Go big or go home“-Sweatshirt trägt, erstellt von Stable Diffusion 3.

-

Stabile Diffusion der dritten Generation mit Eingabeaufforderung: Drei Klarglasflaschen auf einem Holztisch. Der linke hat eine rote Flüssigkeit und die Zahl 1. Der mittlere hat eine blaue Flüssigkeit und die Zahl 2. Der rechte hat eine grüne Flüssigkeit und die Zahl 3.

-

KI-generiertes Bild mit Stable Diffusion 3.

-

Stabile Diffusion der dritten Generation mit Eingabeaufforderung: Ein Pferd balanciert auf einem farbigen Ball auf einem Feld mit grünem Gras und einem Berg im Hintergrund.

-

Stilllebenvermehrung der dritten Generation mit Aufforderung: stimmungsvolles Stillleben mit verschiedenen Kürbissen.

-

Stable Diffusion 3. Generation mit Aufforderung: Ein Gemälde eines Astronauten, der auf einem Schwein reitet, das ein Tutu mit einem rosa Regenschirm trägt, auf dem Boden neben dem Schwein ein Rotkehlchen mit Zylinder und in der Ecke die Worte „Stable Diffusion“.

-

Stabile Verbreitung der 3. Generation mit dem Anspruch: Auf dem Küchentisch liegen ein besticktes Tuch mit der Aufschrift „Gute Nacht“ und ein besticktes Tigerbaby. Neben dem Tuch steht eine brennende Kerze. Die Beleuchtung ist schwach und dramatisch.

-

Stabile Verbreitung der 3. Generation mit Eingabeaufforderung: Bild eines Desktop-Computers aus den 90er-Jahren auf einem Schreibtisch, auf dessen Computerbildschirm „Hallo“ steht. An der Wand im Hintergrund sehen wir wunderschöne Graffiti mit dem Text „SD3“ sehr groß an der Wand.

Zu den technischen Verbesserungen sagte Imad Mushtaq, CEO von Stability Bücher Auf der

Wie Mostaque sagte, verwendet die Stable-Familie Diffusion 3 Aufbau von Diffusionstransformatoreneine neue Methode zur Bilderstellung mithilfe künstlicher Intelligenz, die die üblichen Bildbausteine (z. B UNET-Architektur) für ein System, das kleine Teile des Bildes bearbeitet. Diese Methode ist von Transformern inspiriert, die gut mit Mustern und Sequenzen umgehen können. Dieser Ansatz steigert nicht nur die Effizienz, sondern soll auch zu einer höheren Bildqualität führen.

Auch Stable Diffusion 3 kommt zum Einsatz“Durchflussanpassung„, eine Technik zur Erstellung künstlicher Intelligenzmodelle, die Bilder erstellen kann, indem sie lernt, von zufälligem Rauschen zu einem glatt strukturierten Bild zu gelangen. Dies geschieht, ohne dass jeder Schritt des Prozesses simuliert werden muss, und konzentriert sich stattdessen auf die allgemeine Richtung oder den allgemeinen Fluss Es folgt die Bilderstellung.

Wir haben keinen Zugriff auf den Stable Diffusion 3 (SD3), aber anhand der Beispiele, die wir auf der Stable-Website und den zugehörigen Social-Media-Konten gefunden haben, sehen die Generations derzeit in etwa mit anderen modernen Fotomontagemodellen vergleichbar aus. Einschließlich der oben genannten DALL-E 3, Adobe Firefly, Imagine with Meta AI, Midjourney und Google Imagen.

SD3 scheint die Textgenerierung in den von anderen bereitgestellten Beispielen, die wahrscheinlich von Rosinen ausgewählt wurden, sehr gut zu handhaben. Die Textgenerierung war in früheren Bildmontagen eine besondere Schwäche, daher ist die Verbesserung dieser Fähigkeit in der Freiform eine große Sache. Auch die Geschwindigkeitsgenauigkeit (wie genau sie den Beschreibungen in den Eingabeaufforderungen folgt) scheint DALL-E 3 ähnlich zu sein, aber wir haben das noch nicht selbst getestet.

Während Stable Diffusion 3 nicht allgemein verfügbar ist, sagt Stability, dass seine Gewichte nach Abschluss der Tests kostenlos heruntergeladen und lokal ausgeführt werden können. „Diese Vorschauphase ist wie bei früheren Modellen von entscheidender Bedeutung, um Ideen zur Verbesserung der Leistung und Sicherheit vor der öffentlichen Veröffentlichung zu sammeln“, schrieb Stability.

Stabilität wurde kürzlich mit verschiedenen Bildmontagearchitekturen experimentiert. Abgesehen von SDXL und SDXL Turbo kündigte das Unternehmen erst letzte Woche an Stabile Kaskadedas einen dreistufigen Prozess verwendet, um Text über ein Bild zu legen.

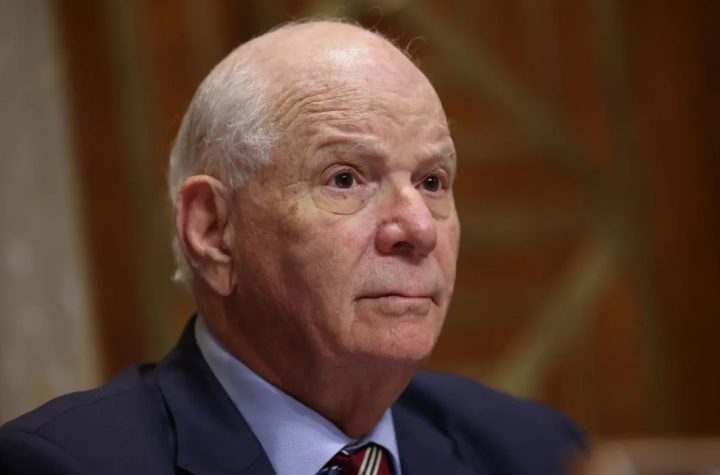

Bild auflisten von Imad Mushtaq (KI für Stabilität)

„Hipsterfreundlicher Entdecker. Preisgekrönter Kaffeefan. Analyst. Problemlöser. Störenfried.“

More Stories

So verwandeln Sie Ihr Zuhause in eine echte Smart Home-Umgebung

Dieses 100-W-GaN-Ladegerät ist dünn und faltbar

Kuo: Das RAM-Upgrade auf 12 GB im nächsten Jahr wird auf das iPhone 17 Pro Max beschränkt sein