OpenAI hat Konten entfernt, die mit bekannten Propagandaoperationen in Russland, China und dem Iran in Verbindung stehen; Israelische Firma für politische Kampagnen; und eine bisher unbekannte Gruppe mit Ursprung in Russland, die die Forscher des Unternehmens als „schlechte Grammatik“ bezeichneten. Die Gruppen nutzten die OpenAI-Technologie, um Beiträge zu schreiben, sie in verschiedene Sprachen zu übersetzen und Software zu erstellen, die ihnen hilft, automatisch in sozialen Medien zu posten.

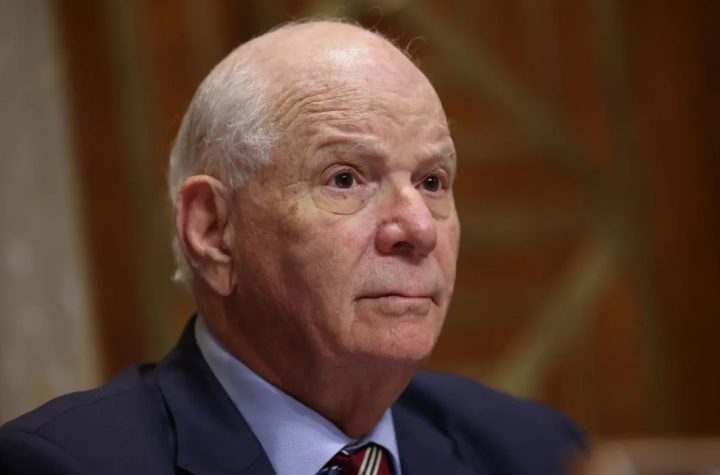

Keine dieser Gruppen konnte große Aufmerksamkeit erregen; Die damit verbundenen Social-Media-Konten erreichten einige wenige Nutzer und hatten „Sie sind nur eine Handvoll Anhänger“, sagte Ben Nimmo, leitender Ermittler im Geheimdienst- und Ermittlungsteam von OpenAI. Der OpenAI-Bericht zeigt jedoch, dass Befürworter, die seit Jahren in den sozialen Medien aktiv sind, KI-Technologie nutzen, um ihre Kampagnen zu verbessern.

„Wir haben gesehen, dass sie Texte in größerem Umfang und mit weniger Fehlern generieren, als diese Prozesse traditionell schaffen“, sagte Nimmo, der zuvor an den Einflussverfolgungsoperationen von Meta gearbeitet hat, in einem Briefing mit Reportern. Nimmo sagte, es sei möglich, dass andere Gruppen ohne Wissen des Unternehmens weiterhin die Tools von OpenAI nutzen.

„Dies ist nicht die Zeit, selbstgefällig zu sein. Die Geschichte zeigt, dass Einflussoperationen, die jahrelang erfolglos waren, plötzlich ausbrechen können, wenn niemand danach sucht.

Regierungen, politische Parteien und Aktivistengruppen nutzen seit Jahren soziale Medien, um Einfluss auf die Politik zu nehmen. Aufgrund der Besorgnis über den russischen Einfluss bei der Präsidentschaftswahl 2016 begannen Social-Media-Plattformen, verstärkt darauf zu achten, wie sie ihre Positionen nutzen könnten, um Wähler zu beeinflussen. Unternehmen verbieten es Regierungen und politischen Gruppen generell, koordinierte Bemühungen zur Beeinflussung von Nutzern zu vertuschen, und politische Anzeigen müssen offenlegen, wer dafür bezahlt hat.

Da KI-Tools, die realistische Texte, Bilder und sogar Videos erzeugen können, immer allgemeiner verfügbar werden, haben Desinformationsforscher Bedenken geäußert, dass es schwieriger werden wird, falsche Informationen oder verdeckte Einflussnahmen im Internet zu erkennen und darauf zu reagieren. Hunderte Millionen Menschen stimmen dieses Jahr weltweit bei Wahlen ab, und KI-generierte Deepfakes haben sich bereits durchgesetzt.

OpenAI, Google und andere KI-Unternehmen arbeiten an Technologien zur Identifizierung von Deepfakes, die mit ihren eigenen Tools erstellt wurden, aber die Technologie ist noch unbewiesen. Einige KI-Experten glauben, dass Deepfake-Detektoren niemals ihre volle Wirksamkeit entfalten werden.

Anfang dieses Jahres veröffentlichte eine der Kommunistischen Partei Chinas nahestehende Gruppe eine KI-generierte Audioaufnahme eines Kandidaten bei den Wahlen in Taiwan, der angeblich einen anderen Kandidaten unterstützte. Der Politiker, Foxconn-Eigentümer Terry Gou, unterstützte den anderen Politiker jedoch nicht.

Im Januar erhielten die Vorwahlwähler in New Hampshire einen Robocall, der angeblich von Präsident Biden stammte, sich aber schnell herausstellte, dass er mit künstlicher Intelligenz ausgestattet war. Letzte Woche wurde ein demokratischer Aktivist, der sagte, er sei mit dem Robocall beauftragt worden, wegen Wählerunterdrückung und Nachahmung eines Kandidaten angeklagt.

Der OpenAI-Bericht beschreibt detailliert, wie die fünf Gruppen die Technologie des Unternehmens bei ihren Versuchen, den Betrieb zu beeinflussen, nutzten. Spamoflage, eine zuvor bekannte Gruppe mit Ursprung in China, nutzte die OpenAI-Technologie, um Aktivitäten in sozialen Medien zu recherchieren und Beiträge auf Chinesisch, Koreanisch, Japanisch und Englisch zu verfassen, sagte das Unternehmen. Eine iranische Gruppe namens International Virtual Media Consortium nutzte ebenfalls die OpenAI-Technologie, um Artikel zu erstellen, die sie auf ihrer Website veröffentlichte.

Die bisher unbekannte Gruppe Bad Grammar nutzte die OpenAI-Technologie, um bei der Entwicklung von Software zu helfen, die automatisch in der Messaging-App Telegram posten kann. Bad Grammar nutzte dann die OpenAI-Technologie, um Beiträge zu erstellen und In Kommentaren auf Russisch und Englisch wird argumentiert, dass die USA die Ukraine nicht unterstützen sollten, heißt es in dem Bericht.

Der Bericht stellte auch fest, dass eine israelische politische Kampagnenfirma namens Stoic OpenAI nutzte, um pro-israelische Beiträge über den Gaza-Krieg zu erstellen und diese an Menschen in Kanada, den Vereinigten Staaten und Israel zu richten, so OpenAI. Am Mittwoch machte auch Facebook-Inhaberin Meta die Aktionen von Stoic öffentlich und sagte, sie habe 510 von der Gruppe verwendete Facebook-Konten und 32 Instagram-Konten entfernt. Das Unternehmen teilte Reportern mit, dass einige Konten gehackt wurden, während andere falschen Personen gehörten.

Die fraglichen Berichte wurden häufig auf den Seiten bekannter Personen oder Medienorganisationen kommentiert und gaben sich als pro-israelische amerikanische College-Studenten, Afroamerikaner und andere aus. Meta sagte, die Kommentare unterstützten das israelische Militär und warnten die Kanadier, dass der „radikale Islam“ dort liberale Werte bedrohe.

Künstliche Intelligenz spielte bei der Erstellung einiger Kommentare eine Rolle, die echten Facebook-Nutzern seltsam und aus dem Zusammenhang gerissen vorkamen. Das Unternehmen sagte, der Betrieb sei schlecht gewesen und habe nur etwa 2.600 legitime Follower angezogen.

Meta handelte nach dem Digital Forensic Research Laboratory des Atlantic Council Entdecken Netzwerk auf X

Im vergangenen Jahr haben Desinformationsforscher vorgeschlagen, dass KI-gestützte Chatbots dazu genutzt werden könnten, lange, detaillierte Gespräche mit bestimmten Personen im Internet zu führen und so zu versuchen, sie in eine bestimmte Richtung zu beeinflussen. KI-Tools können auch große Mengen an Daten über Einzelpersonen aufnehmen und Nachrichten direkt an sie anpassen.

OpenAI habe keine dieser anspruchsvolleren Anwendungen für KI gefunden, sagte Nimmo. Er fügte hinzu: „Es ist eine Evolution, keine Revolution.“ „Das alles bedeutet nicht, dass wir das in Zukunft möglicherweise nicht mehr sehen werden.“

Joseph Main hat zu diesem Bericht beigetragen.

„Amateur-Organisator. Möchtegern-Bier-Evangelist. Allgemeiner Web-Fan. Zertifizierter Internet-Ninja. Begeisterter Leser.“

More Stories

Die Freigabe wurde nach einer offensichtlich vorzeitigen Veröffentlichung eingestellt

Die Aktien des Chipriesen für künstliche Intelligenz Nvidia gaben trotz seines Rekordumsatzes von 30 Milliarden US-Dollar nach

Yelp verklagt Google wegen Kartellverstößen