Getty Images | Alexander Ecke

Anscheinend hat Google versehentlich eine große Anzahl interner technischer Dokumente auf GitHub veröffentlicht, die teilweise erklären, wie die Suchmaschine Webseiten einordnet. Für die meisten von uns lautet die Frage in Bezug auf Suchrankings nur: „Sind meine Webergebnisse gut oder schlecht?“, aber die SEO-Community ist begeistert, einen Blick hinter die Kulissen zu werfen und in die Arme zu gehen, da die Dokumente einigen von Google bereitgestellten Dokumenten zu widersprechen scheinen hat es ihnen in der Vergangenheit gesagt. Die meisten Kommentare zu dem Leak stammen von SEO-Experten. Rand Fishkin Und Mike King.

Google bestätigte die Echtheit der Dokumente die Kante„Wir warnen davor, ungenaue Annahmen über die Forschung zu treffen, die auf nicht kontextbezogenen, veralteten oder unvollständigen Informationen basieren“, sagte er. „Wir haben umfassende Informationen darüber ausgetauscht, wie Forschung funktioniert und welche Arten von Faktoren unsere Systeme messen, während wir gleichzeitig daran arbeiten.“ die Integrität unserer Ergebnisse vor Manipulation schützen.“

Das Lustige an der versehentlichen Veröffentlichung auf GoogleAPI GitHub ist, dass Google sie, obwohl es sich um vertrauliche interne Dokumente handelt, technisch gesehen unter der Apache 2.0-Lizenz veröffentlicht hat. Dies bedeutet, dass jeder, der die Dokumente gefunden hat, eine „unbefristete, weltweite, nicht exklusive, gebührenfreie, unwiderrufliche Urheberrechtslizenz“ erhalten hat, sodass sie jetzt online frei verfügbar sind Hier.

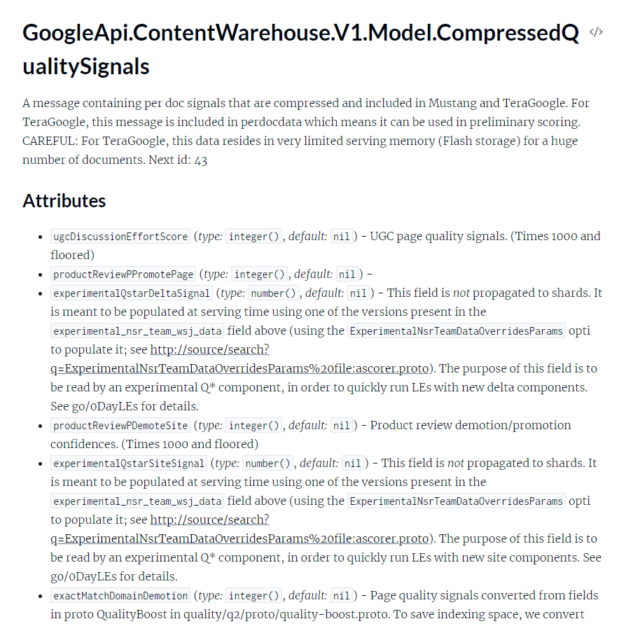

Das Leak enthält zahlreiche API-Dokumentationen für Googles „ContentWarehouse“, das einem Suchindex sehr ähnlich ist. Wie zu erwarten wäre, wäre selbst diese unvollständige Ansicht darüber, wie Google Webseiten einordnet, unglaublich komplex. King schrieb, dass „in der API-Dokumentation 2.596 Module mit 14.014 Attributen dargestellt sind“. Dies sind alles Dokumente, die von Programmierern für Programmierer geschrieben wurden und auf vielen grundlegenden Informationen basieren, die Sie wahrscheinlich nicht kennen würden, wenn Sie nicht in einem Forschungsteam arbeiten würden. Die SEO-Community studiert die Dokumente noch immer und nutzt sie, um Annahmen darüber zu treffen, wie die Google-Suche funktioniert.

Sowohl Fishkin als auch King werfen Google vor, in der Vergangenheit SEO-Experten „gelogen“ zu haben. Eine der Enthüllungen in den Dokumenten ist, dass die CTR einer Suchergebnisseite das Ranking beeinflusst, was eine Sache von Google ist Er bestritt es Er versucht, die Ergebnisse mehrmals zu „aufpeppen“. Das Klick-Tracking-System heißt „Navboost“, das heißt, es steigert die Anzahl der Websites, die Benutzer besuchen. Natürlich stammen viele dieser Klickdaten von Chrome, auch wenn Sie die Suche verlassen. Einige Ergebnisse könnten beispielsweise eine kleine Gruppe von Sitemap-Ergebnissen unterhalb des Hauptmenüs anzeigen, die Teil dessen sind, was diese beliebteren Unterseiten zu unterstützen scheint, wie durch das Klick-Tracking von Chrome ermittelt.

Aus den Dokumenten geht auch hervor, dass Google über Whitelists verfügte, die bestimmte Websites für bestimmte Themen künstlich ankurbeln würden. Die beiden genannten sind „isElectionAuthority“ und „isCovidLocalAuthority“.

Ein Großteil der Dokumentation entspricht genau der Funktionsweise einer Suchmaschine. Websites verfügen über einen „SiteAuthority“-Wert, der bekannte Websites höher einordnet als weniger beliebte Websites. Die Autoren haben auch ihre eigenen Klassifizierungen, aber wie bei allem hier ist es unmöglich zu wissen, wie alles mit allem anderen interagiert.

Beide Kommentare von SEO-Experten lassen sie scheinbar verärgert darüber sein, dass Google sie überhaupt in die Irre führen würde, aber muss das Unternehmen nicht zumindest ein leicht kontroverses Verhältnis zu Leuten pflegen, die versuchen, Suchergebnisse zu manipulieren? Eine aktuelle Studie ergab, dass „Suchmaschinen das Katz-und-Maus-Spiel mit SEO-Spam zu verlieren scheinen“ und fand „einen umgekehrten Zusammenhang zwischen dem Grad der Seitenoptimierung und der wahrgenommenen Fachkompetenz, was darauf hindeutet, dass SEO zumindest die subjektive Seitenqualität beeinträchtigen könnte.“ „Keine dieser zusätzlichen Dokumentationen wird den Nutzern oder der Qualität der Google-Ergebnisse zugute kommen. Da die Leute beispielsweise wissen, dass sich die CTR auf Suchrankings auswirkt, könnten Sie Ihren Website-Eintrag nicht mit einer Klickfarm verbessern?

„Hipsterfreundlicher Entdecker. Preisgekrönter Kaffeefan. Analyst. Problemlöser. Störenfried.“

More Stories

Dieses 100-W-GaN-Ladegerät ist dünn und faltbar

Kuo: Das RAM-Upgrade auf 12 GB im nächsten Jahr wird auf das iPhone 17 Pro Max beschränkt sein

Verdansk kehrt endlich zu Call of Duty Warzone zurück und die Fans freuen sich darüber