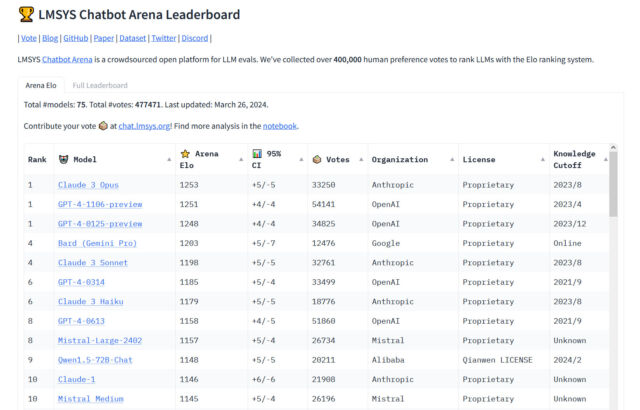

Am Dienstag übertraf Anthropics Claude 3 Opus Large Language Model (LLM) zum ersten Mal das GPT-4-Modell von OpenAI (das ChatGPT antreibt) auf Chatbot Arena, einer beliebten Crowdsourcing-Website. Bestenlisten Es wird von KI-Forschern verwendet, um die relativen Fähigkeiten von KI-Sprachmodellen zu messen. „Der König ist tot,“ zwitschern Softwareentwickler Nick Dobos in einem Beitrag, der GPT-4 Turbo und Claude 3 Opus vergleicht und der in den sozialen Medien verbreitet wurde. „GPT-4 rippen.“

Seit GPT-4 in Chatbot Arena enthalten ist Ungefähr am 10. Mai 2023 (Die Bestenliste wurde gestartet 3. Mai In diesem Jahr standen Versionen von GPT-4 bisher durchweg an der Spitze der Tabelle, daher ist seine Niederlage in der Arena ein bemerkenswerter Moment in der relativ kurzen Geschichte der KI-Sprachmodelle. Eines der kleineren Modelle von Anthropic, Haiku, sorgte mit seiner Leistung auf der Bestenliste ebenfalls für Aufsehen.

„Zum ersten Mal stammen die besten verfügbaren Modelle – Opus für fortgeschrittene Aufgaben, Haiku für Kosten und Effizienz – von einem anderen Anbieter als OpenAI“, sagte der unabhängige KI-Forscher Simon Willison gegenüber Ars Technica. „Das ist beruhigend – wir alle profitieren von der Vielfalt der großen Anbieter in diesem Bereich. Aber GPT-4 ist zu diesem Zeitpunkt über ein Jahr alt, und es hat dieses Jahr gedauert, bis alle anderen aufgeholt haben.“

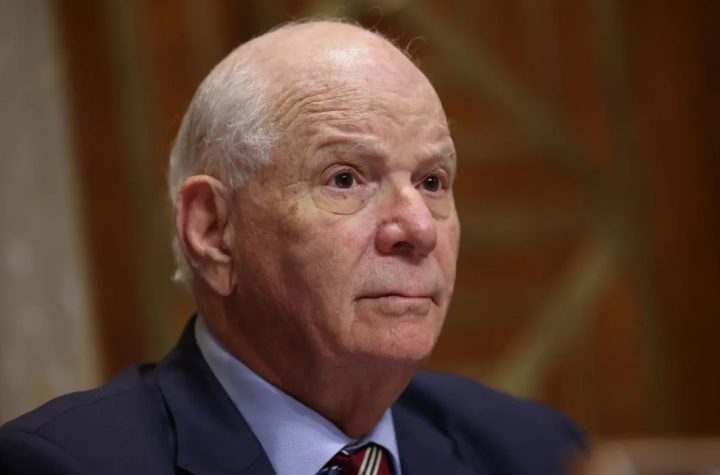

Bing Edwards

Chatbot Arena wird verwaltet Große Modellsystemorganisation (LMSYS ORG), eine Forschungsorganisation, die sich offenen Modellen widmet und als Zusammenarbeit zwischen Studierenden und Lehrkräften der University of California, Berkeley, der University of California, San Diego und der Carnegie Mellon University fungiert.

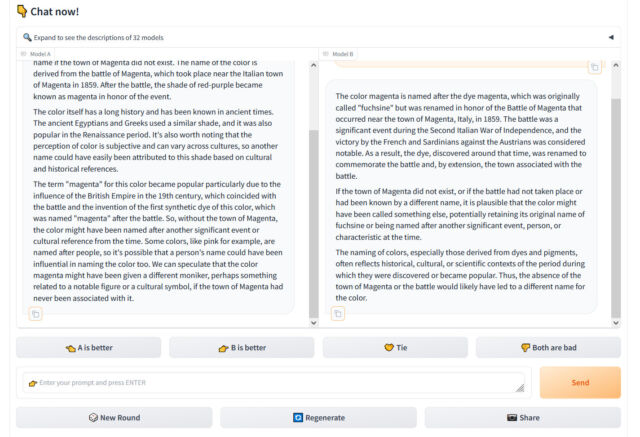

Wir haben bereits im Dezember beschrieben, wie die Website funktioniert, aber kurz gesagt: Chatbot Arena präsentiert einem Benutzer, der die Website besucht, ein Chat-Eingabefeld und zwei Fenster, in denen die Ergebnisse von zwei unbenannten MBAs angezeigt werden. Die Aufgabe des Benutzers besteht darin, anhand der Kriterien, die er für am geeignetsten hält, zu bewerten, welche Ausgabe am besten ist. Durch Tausende dieser personalisierten Vergleiche berechnet Chatbot Arena insgesamt die „besten“ Modelle, füllt die Bestenliste und aktualisiert sie im Laufe der Zeit.

Chatbot Arena ist wichtig, da Forscher und Benutzer gleichermaßen oft frustriert sind, wenn sie versuchen, die Leistung von KI-gestützten Chatbots zu messen, deren stark variierende Ergebnisse schwer zu messen sind. Tatsächlich haben wir in unserem Nachrichtenartikel über die Einführung von Cloud 3 darüber geschrieben, wie schwierig es ist, einen Master-Abschluss objektiv zu messen. In dieser Geschichte betonte Willison die wichtige Rolle von „Gefühlen“ oder subjektiven Gefühlen bei der Bestimmung der Qualität von arbeiten. Master. „Es ist ein weiterer Fall, dass Emotionen ein Schlüsselkonzept in der modernen KI sind“, sagte er.

Bing Edwards

Im KI-Bereich herrscht häufig eine „gute Stimmung“, wo numerische Benchmarks, die Wissen oder Testfähigkeiten messen, von Anbietern häufig übernommen werden, um ihre Ergebnisse relevanter erscheinen zu lassen. „Ich hatte gerade eine lange Programmiersitzung mit Claude 3 Opus und der Mensch hat gpt-4 völlig zerstört. Ich glaube nicht, dass die Benchmarks diesem Modell gerecht werden.“ zwitschern KI-Softwareentwickler Anton Bakaj am 19. März.

Der Aufstieg von Claude könnte OpenAI zum Erliegen bringen, aber wie Willison erwähnte, ist die GPT-4-Familie selbst (obwohl sie mehrmals aktualisiert wurde) mehr als ein Jahr alt. Derzeit listet Arena vier verschiedene Versionen von GPT-4 auf, bei denen es sich um inkrementelle Aktualisierungen von LLM handelt, die im Laufe der Zeit hängen bleiben, weil jede über einen einzigartigen Ausgabestil verfügt und einige Entwickler, die sie mit der API von OpenAI verwenden, Konsistenz benötigen, damit ihre Anwendungen darauf aufbauen können GPT-Ausgabe. -4.

Dazu gehört GPT-4-0314 (die „native“ Version von GPT-4 von März 2023), GPT-4-0613 (Momentaufnahme von GPT-4 vom 13. Juni 2023, mit „verbesserter Funktionsaufrufunterstützung“, entsprechend OpenAI), GPT-4-1106-preview (Startversion von GPT-4 Turbo ab November 2023) und GPT-4-0125-preview (neuestes Modell von GPT-4 Turbo, soll ab Januar 2024 „faule“ Instanzen reduzieren ).

Doch selbst mit vier GPT-4-Modellen auf der Bestenliste sind die Claude 3-Modelle von Anthropic seit ihrer Veröffentlichung Anfang dieses Monats kontinuierlich in den Charts aufgestiegen. Der Erfolg von Claude 3 unter AI Assistant-Benutzern hat einige LLM-Benutzer dazu veranlasst, ChatGPT in ihrem täglichen Arbeitsablauf zu ersetzen, was möglicherweise den Marktanteil von ChatGPT schmälert. Auf X, Softwareentwickler Pietro Schirano Bücher„Ehrlich gesagt ist das Brutalste an Cloud 3 > GPT-4, wie einfach der Wechsel ist??“

Googles ähnlich leistungsfähiger Gemini Advanced hat auch im Bereich der KI-Assistenten an Bedeutung gewonnen. Dies mag OpenAI vorerst in Bedrängnis bringen, aber langfristig baut das Unternehmen neue Modelle auf. Ein wichtiger neuer Nachfolger von GPT-4 Turbo (ob GPT-4.5 oder GPT-5 genannt) wird voraussichtlich irgendwann in diesem Jahr, möglicherweise im Sommer, veröffentlicht. Es ist klar, dass der LLM-Bereich derzeit voller Konkurrenz sein wird, was in den kommenden Monaten und Jahren zu weiteren interessanten Änderungen in der Rangliste der Chatbot Arena führen könnte.

„Hipsterfreundlicher Entdecker. Preisgekrönter Kaffeefan. Analyst. Problemlöser. Störenfried.“

More Stories

So verwandeln Sie Ihr Zuhause in eine echte Smart Home-Umgebung

Dieses 100-W-GaN-Ladegerät ist dünn und faltbar

Kuo: Das RAM-Upgrade auf 12 GB im nächsten Jahr wird auf das iPhone 17 Pro Max beschränkt sein